Convergenza di Variabili Aleatorie

Convergenza in probabilità e quasi certa

Tutti i risultati di questo paragrafo sono enunciati per variabili aleatorie reali, ma sono validi per variabili aleatorie a valori in \mathbb{R}^d. Inoltre alcuni risultati (ad esempio l’unicità del limite) risulta corretto solo se si considerano classi di equivalenza di variabili aleatorie (identificando due variabili che coincidono q.c.).

Supponiamo fissato uno spazio di probabilità (\Omega, \mathcal{F}, \mathbb{P}) e ricordiamo che (per 1 \le p < +\infty) si indica con L^p(\Omega, \mathcal{F}, \mathbb{P}) lo spazio delle (classi di equivalenza delle) variabili aleatorie X tali che \mathbb{E}[|X|^p] < +\infty. Grazie alla diseguaglianza di Minkowski il numero \|X\|_p = (\mathbb{E}[|X|^p])^{1/p} è una norma su L^p, e di conseguenza d(X, Y) = \|X - Y\|_p è una distanza su L^p. (La diseguaglianza di Minkowski sarà dimostrata in appendice).

Viceversa lo spazio L^\infty(\Omega, \mathcal{F}, \mathbb{P}) è lo spazio delle variabili aleatorie X per le quali esiste una costante M tale che si abbia |X(\omega)| \le M q.c., e la norma \|X\|_\infty è la minima delle costanti maggioranti (anche l’esistenza di questa costante minima sarà provata in appendice).

Sia dunque assegnata una successione di variabili aleatorie reali (X_n)_{n \ge 1} (naturalmente i limiti si intendono per n \to \infty).

§ Definizione. Si dice che (X_n)_{n \ge 1} converge a X in probabilità se, \forall \varepsilon > 0, \lim_n \mathbb{P}\{|X_n - X| > \varepsilon\} = 0.

§ Definizione. Si dice che (X_n)_{n \ge 1} converge a X quasi certamente se, per quasi ogni \omega, la successione di numeri X_n(\omega) converge a X(\omega). Può anche essere espresso come

\mathbb P [ \lim_n X_n = X ] = 1§ Definizione. Si dice che (X_n)_{n \ge 1} converge a X in L^p se ogni X_n (ed X) appartiene a L^p e \lim_n \|X_n - X\|_p = 0.

§ Proposizione. Se q \le p, allora la convergenza in L^p implica la convergenza in L^q.

§ Proposizione. Se X_n converge a X in L^p, allora X_n \to X in probabilità.

Dimostrazione. Se 1 \le p < +\infty, l’affermazione è una conseguenza immediata della diseguaglianza, valida per \varepsilon > 0,

\varepsilon^p \mathbb{P}\{|X_n - X| > \varepsilon\} \le \mathbb{E}[|X_n - X|^p]Viceversa, nel caso p = +\infty, segue dal fatto che la convergenza in L^\infty è evidentemente più forte della convergenza q.c.

§ Proposizione. Se X_n \to X quasi certamente, allora X_n \to X in probabilità.

Dimostrazione. Ricordiamo che si definisce \limsup_n A_n = \{\omega \mid \omega \text{ appartiene a infiniti } A_n\}, e che vale la diseguaglianza \limsup_n \mathbb{P}(A_n) \le \mathbb{P}(\limsup_n A_n).

Dato \varepsilon > 0, l’insieme \limsup_n \{|X_n - X| > \varepsilon\} è trascurabile e pertanto

\limsup_n \mathbb{P}\{|X_n - X| > \varepsilon\} \le \mathbb{P}(\limsup_n \{|X_n - X| > \varepsilon\}) = 0§ Proposizione. Se X_n \to X in probabilità, allora esiste una sottosuccessione X_{n_k} tale che X_{n_k} \to X quasi certamente.

Dimostrazione. Possiamo estrarre una sottosuccessione n_1 < n_2 < \dots tale che si abbia

\mathbb{P}\{|X_{n_k} - X| > \frac{1}{k}\} \le 2^{-k}In particolare, la serie \sum_k \mathbb{P}\{|X_{n_k} - X| > \frac{1}{k}\} è una geometrica convergente. Dunque, dal Lemma di Borel-Cantelli segue che, per quasi ogni \omega, definitivamente |X_{n_k}(\omega) - X(\omega)| \le \frac{1}{k} (e questo implica la convergenza quasi certa della sottosuccessione).

Esempio 4.1.3. Sullo spazio [0, 1] munito della misura di Lebesgue, consideriamo la seguente successione di variabili aleatorie, X_1 = \bbone_{[0,1]}, X_2 = \bbone_{[0, \frac{1}{2}]}, X_3 = \bbone_{[\frac{1}{2}, 1]}, X_4 = \bbone_{[0, \frac{1}{4}]} e così via… Questa successione di variabili aleatorie converge in probabilità a 0, ma non converge in nessun punto a 0.

La convergenza in probabilità può essere caratterizzata tramite la convergenza quasi certa nel modo seguente.

§ Proposizione 4.1.4. Sia (X_n)_{n \ge 1} una successione di variabili aleatorie. Sono equivalenti le affermazioni seguenti, a) X_n \to X in probabilità, b) da ogni sottosuccessione si può estrarre una ulteriore sottosuccessione convergente ad X q.c.

Dimostrazione. È evidente che a) implica b); per quanto riguarda il viceversa, supponiamo che la successione (X_n)_{n \ge 1} non converga ad X in probabilità. Ne segue che esistono \varepsilon > 0, \delta > 0 ed una sottosuccessione tale che si abbia per ogni k, \mathbb{P}\{|X_{n_k} - X| > \varepsilon\} > \delta. Ogni ulteriore sottosuccessione verifica quella diseguaglianza e pertanto non può convergere in probabilità né tantomeno q.c.

La caratterizzazione della convergenza in probabilità fornita dalla Proposizione 4.1.4 rende immediate alcune conseguenze (ovvie per la convergenza q.c.) tra le quali ad esempio (la dimostrazione è lasciata per esercizio):

- Il limite della convergenza in probabilità è unico,

- la convergenza quasi certa non proviene da una distanza (più in generale da una topologia),

- se

X_n \to Xin probabilità edfè continua, alloraf(X_n) \to f(X)in probabilità, - se

X_n \to XeY_n \to Yin probabilità, allora passa anche a somma e prodotto ovvero vale:X_n + Y_n \to X + YeX_n Y_n \to XYin probabilità.

§ Proposizione 4.1.5 (variante del teorema di convergenza dominata). Supponiamo che X_n \to X in probabilità e che esista Y integrabile tale che si abbia, per ogni n, |X_n| \le Y. Allora \mathbb{E}[X_n] \to \mathbb{E}[X].

Metrica per la convergenza in probabilità

Sebbene la convergenza quasi certa non provenga da una metrica, la convergenza in probabilità sì. Definiamo la distanza su L^0(\Omega, \mathcal{F}, \mathbb{P}) (lo spazio delle variabili aleatorie finite q.c.) come:

d(X, Y) = \mathbb{E}[|X - Y| \wedge 1]§ Proposizione. La distanza d induce la convergenza in probabilità, cioè X_n \to X in probabilità se e solo se d(X_n, X) \to 0.

Dimostrazione. Supponiamo che X_n \to X in probabilità. Allora |X_n - X| \to 0 in probabilità. Poiché la funzione x \mapsto x \wedge 1 è limitata e continua, per la variante del teorema di convergenza dominata (Proposizione 4.1.5 applicata a |X_n - X| \wedge 1 che è dominata dalla costante 1), si ha \mathbb{E}[|X_n - X| \wedge 1] \to 0, ovvero d(X_n, X) \to 0.

Viceversa, supponiamo che d(X_n, X) \to 0. Sia \varepsilon > 0 e, senza perdere di generalità, supponiamo \varepsilon < 1. Osserviamo che:

\{|X_n - X| \ge \varepsilon\} = \{|X_n - X| \wedge 1 \ge \varepsilon\}Applicando la diseguaglianza di Markov alla variabile aleatoria limitata |X_n - X| \wedge 1:

\mathbb{P}\{|X_n - X| \ge \varepsilon\} = \mathbb{P}\{|X_n - X| \wedge 1 \ge \varepsilon\} \le \frac{1}{\varepsilon} \mathbb{E}[|X_n - X| \wedge 1] = \frac{1}{\varepsilon} d(X_n, X)Poiché d(X_n, X) \to 0, segue che \mathbb{P}\{|X_n - X| \ge \varepsilon\} \to 0.

Osservazione. Più in generale, se g: [0, \infty) \to [0, \infty) è una funzione tale che:

g(0) = 0,gè crescente, continua e limitata,gè strettamente crescente in un intorno di 0,g(x+y) \le g(x) + g(y)(subadditività),

allora d_g(X, Y) = \mathbb{E}[g(|X - Y|)] è una distanza su L^0 che induce la convergenza in probabilità. Nel caso precedente abbiamo usato g(x) = x \wedge 1.

Diciamo che una successione (X_n)_{n \ge 1} è di Cauchy in probabilità se, per ogni \varepsilon > 0 e \delta > 0, esiste \bar{n} tale che, presi n, m > \bar{n}, si abbia \mathbb{P}\{|X_n - X_m| > \varepsilon\} \le \delta.

§ Teorema 4.1.6. Ogni successione di variabili aleatorie di Cauchy in probabilità converge (in probabilità).

Dimostrazione. Si può determinare una sottosuccessione n_1 < n_2 < \dots tale che

\mathbb{P}\{|X_{n_{k+1}} - X_{n_k}| > 2^{-k}\} \le 2^{-k}Per il Lemma di Borel-Cantelli, segue che per quasi ogni \omega, definitivamente |X_{n_{k+1}}(\omega) - X_{n_k}(\omega)| \le 2^{-k} e quindi esiste una variabile aleatoria X tale che X_{n_k} \to X q.c.. Occorre ora provare che tutta la successione converge a X in probabilità.

Prendiamo due indici m > n_k. Dalla relazione insiemistica

\{|X_m - X| > \varepsilon\} \subseteq \{|X_m - X_{n_k}| > \frac{1}{2}\varepsilon\} \cup \{|X_{n_k} - X| > \frac{1}{2}\varepsilon\}segue la diseguaglianza

\mathbb{P}\{|X_m - X| > \varepsilon\} \le \mathbb{P}\{|X_m - X_{n_k}| > \frac{1}{2}\varepsilon\} + \mathbb{P}\{|X_{n_k} - X| > \frac{1}{2}\varepsilon\}È facile a questo punto concludere che, dato \delta > 0, si può determinare un intero \bar{m} = n_k (con k abbastanza grande) tale che, se m \ge \bar{m} si abbia \mathbb{P}\{|X_m - X| > \varepsilon\} \le \delta.

Esaminiamo ora gli spazi L^p. Osserviamo che è immediato verificare che lo spazio L^\infty è completo. Per quanto riguarda gli spazi L^p con 1 \le p < +\infty, la completezza di questi spazi segue rapidamente dai risultati che abbiamo appena visto.

§ Corollario 4.1.7. Lo spazio L^p(\Omega, \mathcal{F}, \mathbb{P}) è completo.

Dimostrazione. Se la successione (X_n)_{n \ge 1} è di Cauchy in L^p, lo è pure in probabilità e quindi esiste per il Teorema 4.1.6 una sottosuccessione ed una variabile aleatoria X tali che X_{n_k} \to X q.c.. Poiché si ha, per il Lemma di Fatou, la diseguaglianza

\int_\Omega |X|^p \, \mathrm d \mathbb{P} \le \liminf_{k \to \infty} \int_\Omega |X_{n_k}|^p \, \mathrm d \mathbb{P}Convergenza di misure in \mathbb{R}

Consideriamo (\mu_n)_{n \ge 1} e \mu misure finite su \mathbb{R}.

§ Definizione. Si dice che \mu_n \to \mu vagamente se \int f(x) \mu_n(dx) \to \int f(x) \mu(dx) per ogni f \in C_c(\mathbb{R}), dove C_c(\mathbb{R}) è lo spazio delle funzioni continue a supporto compatto.

§ Definizione. Si dice che \mu_n \to \mu debolmente se \int f(x) \mu_n(dx) \to \int f(x) \mu(dx) per ogni f \in C_0(\mathbb{R}), dove C_0(\mathbb{R}) è lo spazio delle funzioni continue tali che \lim_{|x| \to \infty} f(x) = 0.

§ Definizione. Si dice che \mu_n \to \mu strettamente se \int f(x) \mu_n(dx) \to \int f(x) \mu(dx) per ogni f \in C_b(\mathbb{R}), dove C_b(\mathbb{R}) è lo spazio delle funzioni continue e limitate.

Osservazione. Poiché C_c(\mathbb{R}) \subset C_0(\mathbb{R}) \subset C_b(\mathbb{R}), si ha che la convergenza stretta implica quella debole, che a sua volta implica quella vaga. In generale non vale il viceversa.

Esempio. Sia \mu_n = n \delta_n. Allora \mu_n \to 0 vagamente. Infatti per ogni f \in C_c(\mathbb{R}), f(n) = 0 per n abbastanza grande, quindi \int f \mu_n = n f(n) = 0.

D’altra parte, se consideriamo f \in C_0(\mathbb{R}) tale che f(x) \sim \frac{1}{\sqrt{|x|}} per x grande, si ha \int f \mu_n = n f(n) \sim \sqrt{n} \to \infty.

Esempio. Sia \mu_n = \frac{1}{n} \bbone_{[0, n]}.

\mu_n \to 0vagamente: per ognif \in C_c(\mathbb{R}),\int f \mu_n = \frac{1}{n} \int_0^n f(x) dx \to 0(poiché l’integrale è costante perngrande).- Tuttavia

\int \bbone \mu_n = 1, mentre\int \bbone \mu = 0, quindi non converge strettamente.

§ Teorema (Cesaro). Se f(x) \to 0 per x \to \infty, allora \frac{1}{n} \int_0^n f(x) dx \to 0.

Dimostrazione. Sia \varepsilon > 0. Esiste x_\varepsilon tale che |f(x)| \le \varepsilon per ogni x \ge x_\varepsilon. Allora

\left| \frac{1}{n} \int_0^n f(x) dx \right| \le \frac{1}{n} \left| \int_0^{x_\varepsilon} f(x) dx \right| + \frac{1}{n} \int_{x_\varepsilon}^n |f(x)| dx \le \frac{1}{n} \left| \int_0^{x_\varepsilon} f(x) dx \right| + \frac{n - x_\varepsilon}{n} \varepsilonPassando al limite per n \to \infty, si ottiene \limsup_n | \frac{1}{n} \int_0^n f(x) dx | \le \varepsilon. Per l’arbitrarietà di \varepsilon, il limite è 0.

§ Proposizione 1. Siano (\mu_n)_{n \ge 1} e \mu misure finite. Sono equivalenti:

\mu_n \to \mustrettamente,\mu_n \to \muvagamente e\mu_n(\mathbb{R}) \to \mu(\mathbb{R}).

Dimostrazione. Ci si può ridurre al caso f \ge 0 e f \le 1.

(\Rightarrow) Segue dalla definizione (prendendo f = \bbone \in C_b).

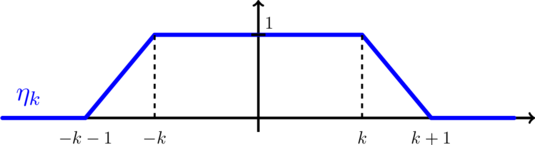

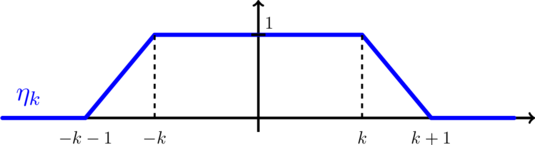

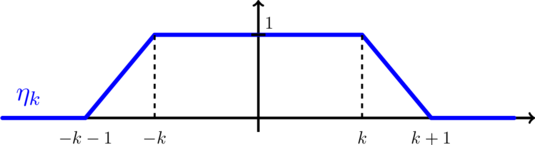

(\Leftarrow) Sia f \in C_b(\mathbb{R}) con 0 \le f \le 1. Sia \eta_k una successione di funzioni in C_c tali che \eta_k \uparrow 1 (ad esempio funzioni trapezoidali come in figura). Definiamo f_k = \eta_k f \in C_c. Allora f_k \uparrow f.

Per ogni k fissato, \int f_k \mu_n \to \int f_k \mu per n \to \infty. Poiché f_k \le f, si ha \int f_k \mu = \lim_n \int f_k \mu_n \le \liminf_n \int f \mu_n.

Per convergenza monotona, \int f \mu = \lim_k \int f_k \mu, quindi \int f \mu \le \liminf_n \int f \mu_n.

Applicando lo stesso ragionamento a \bbone - f \ge 0, si ottiene:

\mu(\mathbb{R}) - \int f \mu \le \liminf_n (\mu_n(\mathbb{R}) - \int f \mu_n) = \mu(\mathbb{R}) - \limsup_n \int f \mu_nda cui \limsup_n \int f \mu_n \le \int f \mu. Insieme alla diseguaglianza precedente, ciò prova la tesi.

§ Proposizione 2. Siano (\mu_n)_{n \ge 1} e \mu misure finite. Sono equivalenti:

\mu_n \to \mudebolmente,\mu_n \to \muvagamente e\sup_n \mu_n(\mathbb{R}) < \infty.

Dimostrazione. (Solo \impliedby) Supponiamo \mu_n \to \mu vagamente e \mu_n(\mathbb{R}) \le M. Sia f \in C_0 e \varepsilon > 0. Esiste g \in C_c tale che \|f - g\|_\infty \le \varepsilon. Allora:

\left| \int f \mu - \int f \mu_n \right| \le \left| \int (f - g) \mu \right| + \left| \int g \mu - \int g \mu_n \right| + \left| \int (g - f) \mu_n \right|\le \varepsilon \mu(\mathbb{R}) + \left| \int g \mu - \int g \mu_n \right| + \varepsilon \mu_n(\mathbb{R}) \le \varepsilon (\mu(\mathbb{R}) + M) + \left| \int g \mu - \int g \mu_n \right|Passando al limite per n \to \infty, il secondo termine scompare per convergenza vaga. Per l’arbitrarietà di \varepsilon, si ha la tesi.

Osservazione. Se \mu è una misura finita su \mathbb{R}, la funzione di ripartizione F_\mu(x) = \mu((-\infty, x]) soddisfa:

-

\lim_{x \to -\infty} F_\mu(x) = 0, -

F_\muè monotona crescente, -

F_\muè continua a destra, -

\lim_{x \to +\infty} F_\mu(x) = \mu(\mathbb{R}).

§ Teorema. Sia (\mu_n)_{n \ge 1} una successione di misure di probabilità e \mu una misura finita.

- Se

\mu_n \to \mustrettamente\Rightarrow F_{\mu_n}(x) \to F_\mu(x)in ogni puntoxdi continuità diF_\mu. - Se

F_{\mu_n}(x) \to F_\mu(x)per ognixin un insieme denso di\mathbb{R} \Rightarrow \mu_n \to \muvagamente.

Dimostrazione.

(\Rightarrow) Supponiamo \mu_n \to \mu strettamente.

Sia x \in \mathbb{R} e \delta > 0. Consideriamo una funzione continua f (trapezoidale) tale che \bbone_{(-\infty, x]} \le f \le \bbone_{(-\infty, x+\delta]}. Allora:

\begin{aligned}

F_\mu(x+\delta) = \mu((-\infty, x+\delta]) &\ge \int f \mu = \lim_{n \to \infty} \int f \mu_n \\

&\ge \limsup_{n \to \infty} \mu_n((-\infty, x]) = \limsup_{n \to \infty} F_{\mu_n}(x)

\end{aligned}Per \delta \to 0, sfruttando la continuità a destra di F_\mu, otteniamo F_\mu(x) \ge \limsup_n F_{\mu_n}(x).

Analogamente, considerando una funzione continua g tale che \bbone_{(-\infty, x-\delta]} \le g \le \bbone_{(-\infty, x]}, si ha:

\begin{aligned}

F_\mu(x-\delta) = \mu((-\infty, x-\delta]) &\le \int g \mu = \lim_{n \to \infty} \int g \mu_n \\

&\le \liminf_{n \to \infty} \mu_n((-\infty, x]) = \liminf_{n \to \infty} F_{\mu_n}(x)

\end{aligned}Se x è un punto di continuità per F_\mu, allora F_\mu(x-\delta) \to F_\mu(x) per \delta \to 0, quindi F_\mu(x) \le \liminf_n F_{\mu_n}(x). In conclusione, F_{\mu_n}(x) \to F_\mu(x) in ogni punto di continuità.

(\Leftarrow) Supponiamo F_{\mu_n}(x) \to F_\mu(x) in un insieme denso D \subset \mathbb{R}.

Sia f \in C_c(\mathbb{R}) e \varepsilon > 0. Poiché f è uniformemente continua, esiste \delta > 0 tale che |x-y| \le \delta \implies |f(x)-f(y)| \le \varepsilon.

Sia \text{supp}(f) \subset [-R, R]. Scegliamo punti x_1 < x_2 < \dots < x_k in D tali che x_1 < -R, x_k > R e |x_{i+1}-x_i| \le \delta.

Definiamo la funzione costante a tratti \phi(x) = \sum_{j=1}^{k-1} f(x_j) \bbone_{(x_j, x_{j+1}]}(x). Allora \|f-\phi\|_\infty \le \varepsilon.

Si ha la stima:

\begin{aligned}

\left| \int f \mu - \int f \mu_n \right| &\le \left| \int (f-\phi) \mu \right| + \left| \int \phi \mu - \int \phi \mu_n \right| + \left| \int (\phi-f) \mu_n \right| \\

&\le \varepsilon \mu(\mathbb{R}) + \left| \int \phi \mu - \int \phi \mu_n \right| + \varepsilon \mu_n(\mathbb{R})

\end{aligned}Poiché \int \phi \mu_n = \sum_{j=1}^{k-1} f(x_j) (F_{\mu_n}(x_{j+1}) - F_{\mu_n}(x_j)), per n \to \infty si ha:

\begin{aligned}

\int \phi \mu_n

&= \sum_{j=1}^{k-1} f(x_j) (F_{\mu_n}(x_{j+1}) - F_{\mu_n}(x_j)) \\

&\to \sum_{j=1}^{k-1} f(x_j) (F_\mu(x_{j+1}) - F_\mu(x_j))

= \int \phi \mu

\end{aligned}Ricordando che \mu_n(\mathbb{R}) = 1 in quanto misure di probabilità, si ottiene:

\limsup_{n \to \infty} \left| \int f \mu - \int f \mu_n \right| \le \varepsilon (\mu(\mathbb{R}) + 1)Quindi \limsup_{n \to \infty} | \int f \mu - \int f \mu_n | \le \varepsilon (\mu(\mathbb{R}) + 1). Per l’arbitrarietà di \varepsilon, \mu_n \to \mu vagamente.

Esempio. Sia \mu_n la legge di una Gaussiana \mathcal{N}(0, 1 / n^2) e \mu = \delta_0.

F_{\mu_n}(x) = \frac{n}{\sqrt{2\pi}} \int_{-\infty}^x e^{-\frac{n^2 t^2}{2}} dt = \frac{1}{\sqrt{2\pi}} \int_{-\infty}^{nx} e^{-\frac{y^2}{2}} dyFacendo il cambio di variabile y = n t. Al limite per n \to \infty:

F_{\mu_n}(x) \to \begin{cases} 1 & \text{se } x > 0 \\ 1/2 & \text{se } x = 0 \\ 0 & \text{se } x < 0 \end{cases}Si noti che F_\mu(x) = \bbone_{[0, \infty)}(x), quindi la convergenza vale per ogni x \neq 0.

§ Teorema (Helly). Sia (\mu_n)_{n \ge 1} una successione di misure di probabilità su \mathbb{R}. Allora esiste una sottosuccessione convergente vagamente a una misura finita \mu.

Dimostrazione. Poiché per ogni q \in \mathbb{Q} la successione (F_{\mu_n}(q))_{n \ge 1} è limitata in [0, 1], possiamo utilizzare un argomento diagonale. Sia (q_j)_{j \in \mathbb{N}} un’enumerazione dei razionali:

- Da

(F_{\mu_n}(q_0))estraiamo una sottosuccessione convergenteF_{\mu_{n,0}}(q_0). - Da questa estraiamo una sottosuccessione

F_{\mu_{n,1}}tale che converga inq_1. - Procedendo per induzione, la sottosuccessione diagonale

(F_{\mu_{n_k}})_{k \ge 1}converge in ogniq \in \mathbb{Q}.

Definiamo G(q) = \lim_{k \to \infty} F_{\mu_{n_k}}(q) per ogni q \in \mathbb{Q}. Poiché ogni F_{\mu_{n_k}} è monotona crescente, anche G lo è. Definiamo ora per ogni x \in \mathbb{R}:

F(x) = \inf_{q \in \mathbb{Q}, q > x} G(q)Chiaramente 0 \le F \le 1. Mostriamo le proprietà di F:

-

Monotonia: Siano

x \le y. Seq > y, alloraq > x, quindiF(x) \le G(q). Prendendo l’estremo inferiore suq > y, si haF(x) \le F(y). -

Continuità a destra: Sia

x_n \downarrow x. Per ogniq > x, pernabbastanza grande si hax < x_n < q, quindiF(x_n) \le G(q). Passando al limite,\lim_n F(x_n) \le G(q). Prendendo l’inf suq > x, si ha\lim_n F(x_n) \le F(x). PoichéF(x) \le \lim_n F(x_n)per monotonia, si ha la tesi. -

Convergenza: Sia

xun punto di continuità perF. Per ogni\varepsilon > 0, esistonoq_1, q_2 \in \mathbb{Q}tali cheq_1 < x < q_2eF(x) - \varepsilon \le F(q_1) \le G(q_1)eG(q_2) \le F(q_2) \le F(x) + \varepsilon. Allora:F(x) - \varepsilon \le G(q_1) = \lim_k F_{\mu_{n_k}}(q_1) \le \liminf_k F_{\mu_{n_k}}(x)\limsup_k F_{\mu_{n_k}}(x) \le \lim_k F_{\mu_{n_k}}(q_2) = G(q_2) \le F(x) + \varepsilonPer l’arbitrarietà di

\varepsilon,F_{\mu_{n_k}}(x) \to F(x).

Dalla relazione \mu((a, b]) = F(b) - F(a) si definisce una misura finita \mu tale che \mu_{n_k} \to \mu vagamente. Poiché \sup_n \mu_n(\mathbb{R}) = 1, per la Proposizione 2 la convergenza è anche debole e \mu(\mathbb{R}) \le 1.

Osservazione. In generale \mu(\mathbb{R}) \le \liminf_n \mu_n(\mathbb{R}) = 1. La misura limite \mu potrebbe non essere una misura di probabilità (perdita di massa all’infinito).

Tensione

La condizione di tensione (o tightness) è fondamentale per garantire che il limite di una successione di misure di probabilità sia ancora una misura di probabilità (ovvero che non ci sia “perdita di massa all’infinito”).

§ Definizione. Una famiglia \mathcal{M} di misure di probabilità si dice tesa se per ogni \varepsilon > 0, esiste un compatto K \subset \mathbb{R} tale che:

\forall \mu \in \mathcal{M}, \quad \mu(K^\complement) < \varepsilonEsempi.

- Singola misura: Se

\mathcal{M} = \{\mu\}, allora è tesa. Infatti, per ogni\varepsilon > 0, poiché\bigcup_{m \in \mathbb{N}} [-m, m] = \mathbb{R}, per la continuità della misura si ha\mu([-m, m]) \nearrow \mu(\mathbb{R}) = 1. Dunque esistem \in \mathbb{N}tale che1 - \mu([-m, m]) < \varepsilon, ovvero\mu([-m, m]^\complement) < \varepsilon. - Famiglia finita: Se

\mathcal{M} = \{\mu_1, \dots, \mu_n\}è finita, allora è tesa. Infatti, per ogni\varepsilon > 0, esistono compattiK_1, \dots, K_ntali che\mu_i(K_i^\complement) < \varepsilonper ognii. AlloraK = \bigcup_{i=1}^n K_iè ancora un compatto e, poichéK^\complement \subseteq K_i^\complement, si ha\mu_i(K^\complement) \le \mu_i(K_i^\complement) < \varepsilonper ognii. - Successione convergente: Se

(\mu_n)_{n \ge 1}converge strettamente a una misura di probabilità\mu, allora la famiglia\mathcal{M} = \{\mu_n \mid n \ge 1\}è tesa.

Dimostrazione (Esempio 3). Sia \varepsilon > 0. Poiché \{\mu\} è tesa, esiste un compatto K tale che \mu(K^\complement) < \varepsilon. Sia \alpha > 0 tale che K \subseteq [-\alpha, \alpha], allora \mu([-\alpha, \alpha]^\complement) < \varepsilon.

Consideriamo una funzione continua f “trapezoidale” tale che \bbone_{[-\alpha, \alpha]} \le f \le \bbone_{[-\alpha-1, \alpha+1]} (come in figura).

Dalla convergenza stretta \int f \mu_n \to \int f \mu, e osservando che:

1 - \varepsilon < \mu([-\alpha, \alpha]) \le \int f \mu = \lim_{n \to \infty} \int f \mu_nne segue che per n abbastanza grande (diciamo n > n_\varepsilon), si ha:

\int f \mu_n \ge \int f \mu - \varepsilon \ge 1 - 2\varepsilonDunque, per n > n_\varepsilon:

\mu_n([-\alpha-1, \alpha+1]) \ge \int f \mu_n \ge 1 - 2\varepsilon \implies \mu_n([-\alpha-1, \alpha+1]^\complement) \le 2\varepsilonPer i primi n_\varepsilon termini, essendo un insieme finito, esiste un compatto K' tale che \mu_n(K'^\complement) < 2\varepsilon per ogni n \le n_\varepsilon.

Allora K'' = K' \cup [-\alpha-1, \alpha+1] è il compatto cercato che soddisfa la condizione di tensione per tutta la successione (con 2\varepsilon al posto di \varepsilon).

§ Teorema (Prohorov). Sia \mathcal{M} una famiglia di misure di probabilità. Allora \mathcal{M} è sequenzialmente relativamente compatta per la convergenza stretta \Leftrightarrow \mathcal{M} è tesa.

Dimostrazione.

(\Leftarrow) Supponiamo \mathcal{M} tesa. Sia (\mu_n)_{n \ge 1} \subseteq \mathcal{M} una successione. Per il Teorema di Helly, esiste una sottosuccessione (\mu_{n_k})_{k \ge 1} che converge vagamente (e quindi debolmente, essendo le misure limitate) a una misura finita \mu. Mostriamo che \mu è una misura di probabilità.

Sappiamo che per ogni \varepsilon > 0 esiste \alpha > 0 tale che \mu_{n_k}([-\alpha, \alpha]) \ge 1 - \varepsilon per ogni k. Sia f una funzione continua “trapezoidale” tale che \bbone_{[-\alpha, \alpha]} \le f \le \bbone_{[-\alpha-1, \alpha+1]}.

Allora:

\mu([-\alpha-1, \alpha+1]) \ge \int f \, \mathrm{d}\mu = \lim_{k \to \infty} \int f \, \mathrm{d}\mu_{n_k} \ge \limsup_{k \to \infty} \mu_{n_k}([-\alpha, \alpha]) \ge 1 - \varepsilonFacendo tendere \varepsilon \to 0, si ha \mu(\mathbb{R}) \ge 1 - \varepsilon per ogni \varepsilon, quindi \mu(\mathbb{R}) = 1. Poiché \mu è una misura di probabilità, la convergenza vaga (con \mu_{n_k}(\mathbb{R}) \to \mu(\mathbb{R})) implica la convergenza stretta.

(\Rightarrow) Supponiamo per assurdo che \mathcal{M} non sia tesa. Allora esiste \varepsilon > 0 tale che per ogni compatto K, esiste \mu \in \mathcal{M} con \mu(K) < 1 - \varepsilon.

In particolare, per ogni n \in \mathbb{N}, esiste \mu_n \in \mathcal{M} tale che \mu_n([-n, n]) < 1 - \varepsilon.

Se esistesse una sottosuccessione (\mu_{n_k}) convergente strettamente a una misura di probabilità \mu, allora tale sottosuccessione dovrebbe essere tesa (per l’Esempio 3 visto in precedenza). Ma per costruzione, nessuna sottosuccessione di (\mu_n) può essere tesa, il che è un assurdo.

§ Teorema 4.2.8 (Portmanteau). Siano (\mu_n)_{n \ge 1}, \mu misure di probabilità. Allora sono equivalenti:

\mu_n \to \mustrettamente,\mu(A) \le \liminf_{n \to \infty} \mu_n(A)per ogni apertoA,\mu(C) \ge \limsup_{n \to \infty} \mu_n(C)per ogni chiusoC,\mu(B) = \lim_{n \to \infty} \mu_n(B)per ogni BorelianoBtale che\mu(\partial B) = 0,\int f \mu(dx) \le \liminf_{n \to \infty} \int f \mu_n(dx)per ogniflimitata e semicontinua inferiormente,\int f \mu(dx) \ge \limsup_{n \to \infty} \int f \mu_n(dx)per ogniflimitata e semicontinua superiormente,\int f \mu(dx) = \lim_{n \to \infty} \int f \mu_n(dx)per ognifBoreliana limitata e tale che l’insieme dei suoi punti di discontinuità sia trascurabile per la misura limite\mu.

Convergenza in legge

§ Definizione. Siano (X_n)_{n \ge 1} e X variabili aleatorie a valori in \mathbb{R}^d. Si dice che (X_n)_{n \ge 1} converge in legge a X se

\forall f \in C_b: \quad

\mathbb{E}[f(X_n)] \xrightarrow{n} \mathbb{E}[f(X)]Osservazione. Osserviamo che \mathbb{E}[f(X)] = \int f(x) P_X(dx), dunque la convergenza in legge equivale alla convergenza stretta delle leggi P_{X_n} \to P_X.

§ Proposizione. Valgono le seguenti proprietà:

-

Se

X_n \to Xin legge egè continua, allorag(X_n) \to g(X)in legge. -

X_n \to Xin probabilità\implies X_n \to Xin legge. -

Se

X_n \to c(costante) in legge, alloraX_n \to cin probabilità.

Dimostrazione.

-

Sia

f \in C_b. Alloraf \circ g \in C_bper la continuità dige la limitatezza dif. -

Supponiamo

X_n \to Xin probabilità. Siaf \in C_b, allora da ogni sottosuccessione(X_{n_k})_{k \ge 1}si può estrarre una sottosottosuccessione(X_{n_{k_j}})_{j \ge 1}che converge aXquasi certamente. Per la continuità dif, si haf(X_{n_{k_j}}) \to f(X)q.c. e, poichéfè limitata, per il teorema della convergenza dominata si ha\mathbb{E}[f(X_{n_{k_j}})] \to \mathbb{E}[f(X)]. Dunque ogni sottosuccessione della successione numerica(\mathbb{E}[f(X_n)])_{n \ge 1}ha una sottosottosuccessione convergente a\mathbb{E}[f(X)], il che implica che tutta la successione converge a\mathbb{E}[f(X)]. -

Per la convergenza in probabilità a una costante

c, vogliamo mostrare che\mathbb{E}[1 \wedge |X_n - c|] \to 0. La funzionef(x) = 1 \wedge |x - c|è continua e limitata. Per l’ipotesi di convergenza in legge, si ha\mathbb{E}[f(X_n)] \to \mathbb{E}[f(c)] = 1 \wedge |c - c| = 0, che prova la tesi.

Osservazioni. In generale la convergenza in legge non garantisce la convergenza in probabilità.

Per esempio, sia U una variabile aleatoria di Bernoulli di parametro 1/2. Definiamo:

X_n = \begin{cases} U & \text{se } n \text{ è dispari} \\ 1 - U & \text{se } n \text{ è pari} \end{cases}Allora X_n ha la stessa legge di U per ogni n (infatti sia U che 1-U sono B(1/2)), quindi X_n \to U in legge.

Tuttavia, se X_n \to X in probabilità, allora per ogni \varepsilon > 0 si dovrebbe avere \mathbb{P}(|X_n - X| \ge \varepsilon) \to 0.

Per n dispari questo darebbe \mathbb{P}(|U - X| \ge \varepsilon) \to 0, quindi X = U q.c.

Per n pari questo darebbe \mathbb{P}(|1 - U - X| \ge \varepsilon) \to 0, quindi X = 1 - U q.c.

Ma allora U = 1 - U q.c., ovvero 2U = 1 q.c., il che è assurdo per una Bernoulli.

Analogamente, se (X_n)_{n \ge 1} è una successione di variabili aleatorie indipendenti e con la stessa legge, allora (X_n)_{n \ge 1} converge in legge ma non in probabilità.

Un’altra cosa da osservare è che se X_n \to X e Y_n \to Y in legge, non è detto che X_n + Y_n \to X + Y in legge. Per esempio, presa Z \sim \mathcal{N}(0, 1), consideriamo le successioni X_n = Z \to Z e Y_n = -Z \to -Z. Allora X_n + Y_n = 0, che non tende a una gaussiana (mentre X + Y = Z - Z = 0 ha legge \delta_0, ma se avessimo preso X e Y indipendenti la legge sarebbe stata diversa).

Però se (X_n, Y_n) \to (X, Y) in legge allora, poiché g(x, y) = x + y è continua, X_n + Y_n \to X + Y in legge.

§ Teorema. Siano (X_n)_{n \ge 1} e X variabili aleatorie reali. Sono equivalenti:

X_n \to Xin legge.F_{X_n}(t) \to F_X(t)in tutti i puntitin cuiF_Xè continua.F_{X_n}(t) \to F_X(t)su un insieme denso di\mathbb{R}.

Esempio. Sia X_n \sim \mathcal{N}(0, 1/n^2). Allora:

F_{X_n}(t) \to \begin{cases} 1 & t > 0 \\ 1/2 & t = 0 \\ 0 & t < 0 \end{cases}mentre la funzione di ripartizione del limite X = 0 (ovvero \delta_0) è:

F_X(t) = \begin{cases} 1 & t \ge 0 \\ 0 & t < 0 \end{cases}Si nota che la convergenza F_{X_n}(t) \to F_X(t) vale per ogni t \neq 0, che sono esattamente i punti di continuità di F_X.

§ Teorema (di Lévy). Siano (X_n)_{n \ge 1} e X variabili aleatorie.

- Se

X_n \to Xin legge, allora\phi_{X_n}(t) \to \phi_X(t)puntualmente. - Se

(\phi_{X_n})_{n \ge 1}converge puntualmente a una funzione\phicontinua in 0, allora\phiè la funzione caratteristica di una variabile aleatoriaXeX_n \to Xin legge.

Dimostrazione.

-

Poiché la funzione

x \mapsto e^{itx}è continua e limitata per ognitfissato, la tesi segue direttamente dalla definizione di convergenza in legge:\phi_{X_n}(t) = \mathbb{E}[e^{itX_n}] \to \mathbb{E}[e^{itX}] = \phi_X(t) -

Supponiamo che

\phi_{X_n}(t) \to \phi(t)con\phicontinua in 0. Consideriamo la famiglia di misure\{\mathbb P_{X_n}\}_{n \ge 1}su\mathbb{R}. Se mostriamo che questa famiglia è tesa, allora per il Teorema di Prohorov esiste una sottosuccessione\mathbb P_{X_{n_k}}che converge strettamente a una misura di probabilità\mathbb P_X. SiaXuna variabile aleatoria con legge\mathbb P_X. Allora per il punto 1 si ha\phi_{X_{n_k}}(t) \to \phi_X(t), ma per ipotesi\phi_{X_{n_k}}(t) \to \phi(t), quindi\phi = \phi_X. Poiché la funzione caratteristica determina univocamente la legge, ogni sottosuccessione convergente deve convergere alla stessa legge\mathbb P_X, il che implica che tutta la successione converge in legge aX.Dimostrazione della tensione. Sia

\delta > 0. Per ogni variabile aleatoriaY, vale la diseguaglianza:\mathbb{P}\left(|Y| > \frac{2}{\delta}\right) \le \frac{1}{\delta} \int_{-\delta}^{\delta} (1 - \phi_Y(t)) \, dtInfatti, sostituendo la definizione di funzione caratteristica

\phi_Y(t) = \mathbb{E}[e^{itY}]e scambiando l’ordine di integrazione per il teorema di Fubini-Tonelli (essendo l’integrando limitato):\begin{aligned} \frac{1}{\delta} \int_{-\delta}^{\delta} (1 - \phi_Y(t)) \, dt &= \frac{1}{\delta} \int_{-\delta}^{\delta} \mathbb{E} [1 - e^{itY}] \, dt = \frac{1}{\delta} \mathbb{E} \left[ \int_{-\delta}^{\delta} (1 - e^{itY}) \, dt \right] \end{aligned}Poiché l’integrale della parte immaginaria

\sin(tY)su un intervallo simmetrico è nullo, rimane solo la parte reale:\begin{aligned} \dots &= \frac{1}{\delta} \mathbb{E} \left[ \int_{-\delta}^{\delta} (1 - \cos(tY)) \, dt \right] \\ &= \frac{1}{\delta} \mathbb{E} \left[ \left( t - \frac{\sin(tY)}{Y} \right)_{t=-\delta}^{t=\delta} \right] = \frac{1}{\delta} \mathbb{E} \left[ 2\delta - \frac{2 \sin(\delta Y)}{Y} \right] \\ &= 2 \mathbb{E} \left[ 1 - \frac{\sin(\delta Y)}{\delta Y} \right] \end{aligned}Osserviamo che se

|\delta Y| > 2, allora\left| \frac{\sin(\delta Y)}{\delta Y} \right| \le \frac{1}{|\delta Y|} \le \frac{1}{2}, quindi1 - \frac{\sin(\delta Y)}{\delta Y} \ge \frac{1}{2}. Ne segue:2 \mathbb{E} \left[ 1 - \frac{\sin(\delta Y)}{\delta Y} \right] \ge 2 \mathbb{E} \left[ \left( 1 - \frac{\sin(\delta Y)}{\delta Y} \right) \bbone_{\{|Y| > 2/\delta\}} \right] \ge 2 \cdot \frac{1}{2} \mathbb{P}\left(|Y| > \frac{2}{\delta}\right) = \mathbb{P}\left(|Y| > \frac{2}{\delta}\right)Poiché

\phiè continua in 0 e\phi(0)=1, si ha\lim_{\delta \to 0} \frac{1}{\delta} \int_{-\delta}^{\delta} (1 - \phi(t)) \, dt = 0. Sia\varepsilon > 0. Scegliamo\deltaabbastanza piccolo tale che\frac{1}{\delta} \int_{-\delta}^{\delta} (1 - \phi(t)) \, dt \le \varepsilon. Fissato tale\delta, per il teorema della convergenza dominata (essendo|\phi_{X_n}| \le 1):\frac{1}{\delta} \int_{-\delta}^{\delta} (1 - \phi_{X_n}(t)) \, dt \xrightarrow{n \to \infty} \frac{1}{\delta} \int_{-\delta}^{\delta} (1 - \phi(t)) \, dtQuindi per

nabbastanza grande:\frac{1}{\delta} \int_{-\delta}^{\delta} (1 - \phi_{X_n}(t)) \, dt \le \varepsilon + \frac{1}{\delta} \int_{-\delta}^{\delta} (1 - \phi(t)) \, dt \le 2\varepsilonDalla diseguaglianza iniziale otteniamo che per

ngrande:\mathbb{P}\left(|X_n| > \frac{2}{\delta}\right) \le 2\varepsilonil che prova che la successione

(X_n)_{n \ge 1}è tesa.

Esempio. Sia X_n \sim \mathcal{N}(0, n^2). Allora \phi_{X_n}(t) = e^{-n^2 t^2 / 2}. Al limite:

\phi_{X_n}(t) \to \begin{cases} 1 & t = 0 \\ 0 & t \neq 0 \end{cases}In questo caso la funzione limite non è continua in 0, e infatti la successione non converge in legge (la massa “scappa” all’infinito).

Per passare a variabili aleatorie in \mathbb{R}^d, consideriamo X_n = (X_n^1, \dots, X_n^d). Allora la funzione caratteristica della j-esima componente è data da:

\phi_{X_n^j}(t) = \phi_{X_n}(0, \dots, 0, t, 0, \dots, 0)dove t è nella j-esima posizione. Se \phi_{X_n} \to \phi puntualmente e \phi è continua in 0, allora anche ogni \phi_{X_n^j} converge a una funzione continua in 0, garantendo la tensione delle componenti e quindi della successione vettoriale.

Osservazione. Osserviamo ora che se (X_n^j)_{n \ge 1} è tesa per ogni j \in \{1, \dots, d\}, allora (X_n)_{n \ge 1} è tesa. Infatti:

\mathbb{P}(\|X_n\| > M) \le \sum_{j=1}^d \mathbb{P}\left(|X_n^j| > \frac{M}{\sqrt{d}}\right)perché

\bigcap_{j=1}^d \left\{|X_n^j| \le \frac{M}{\sqrt{d}}\right\} \subseteq \{\|X_n\| \le M\}Metrizzabilità della convergenza in legge

La convergenza in legge è metrizzabile. Esistono diverse distanze che inducono tale convergenza.

§ Definizione (Metrica di Lévy-Prokhorov). Siano \mu, \nu misure finite su \mathbb{R}. La distanza di Lévy-Prokhorov è definita come:

\pi(\mu, \nu) = \inf \{ \varepsilon > 0 : \mu(A) \le \nu(A^\varepsilon) + \varepsilon \text{ e } \nu(A) \le \mu(A^\varepsilon) + \varepsilon \text{ per ogni Boreliano } A \}dove A^\varepsilon = \{ x \in \mathbb{R} : d(x, A) < \varepsilon \} = \bigcup_{x \in A} B_\varepsilon(x).

§ Definizione (Metrica BL). Un’altra metrica è definita tramite funzioni Lipschitziane limitate:

d_{BL}(\mu, \nu) = \sup \left\{ \left| \int f \, d\mu - \int f \, d\nu \right| : \|f\|_\infty \le 1, \text{Lip}(f) \le 1 \right\}dove \text{Lip}(f) = \sup_{x \neq y} \frac{|f(x) - f(y)|}{|x - y|}.

Appendice

§ Proposizione. Siano (X_n)_{n \ge 1} e X variabili aleatorie, allora:

X_n \to Xq.c.\RightarrowX_n \to Xin probabilità\impliesX_n \to Xin legge.